一、前言

在不断发展的计算机科学和人工智能领域,我们一直在探寻如何确保知识传播的稳定性,这成为了一项至关重要的挑战。本序言是我们踏上探索 ControlNet 模型这一重要领域的旅程的开端。ControlNet 模型,作为机器学习领域的一项重要成就,代表了我们在追求信息传播的稳定和受控性方面取得的关键里程碑。

作为一位充满激情、专注于知识的博主,我将带领您深入了解 ControlNet 模型的复杂细节。在信息和数据呈爆炸式增长的时代,我们迫切需要高效、稳定的信息传播机制。ControlNet 模型正是为了实现这一目标而不断演进,它充分利用了人工智能的力量,以管理和优化数字网络中的信息流。

在接下来的篇章中,我们将踏上一段深入探讨 ControlNet 模型核心概念、架构和实际应用的旅程。我们将深入探讨构建这一创新方法的理论基础,并通过实际实施和现实用例来展示它的威力和潜力。

ControlNet 模型融汇了计算机科学的多个重要领域,包括机器学习、网络理论和数据管理。其发展和不断完善是全球科学界合作精神的明证,各个学科领域的专家们齐心协力,共同打造和塑造这一突破性技术。

在我们探索 ControlNet 模型的复杂性时,我诚挚地邀请您加入这场智力之旅。无论您是经验丰富的计算机科学家,渴望加深理解的研究者,还是充满好奇心的爱好者,这次旅程都将为您提供深刻的见解,探索信息在不断互联的世界中的传播方式。

我们将一同揭开 ControlNet 模型的奥秘,为您提供知识和工具,使您能够真正理解其重要性,并为负责任和高效传播信息的不断探讨做出自己的贡献。

二、ControlNet的发展历程

Stable Diffusion是一种著名的生成对抗网络(GAN)模型,其目的是生成高质量、真实的图像。而Control Net则是一种用于控制AI图像生成的插件,它使用条件生成对抗网络(CGAN)技术来生成图像。本文将介绍Stable Diffusion Control Net的发展历程。

在开始介绍Stable Diffusion Control Net的发展历程之前,我们先来了解一下Stable Diffusion和Control Net的基本概念。

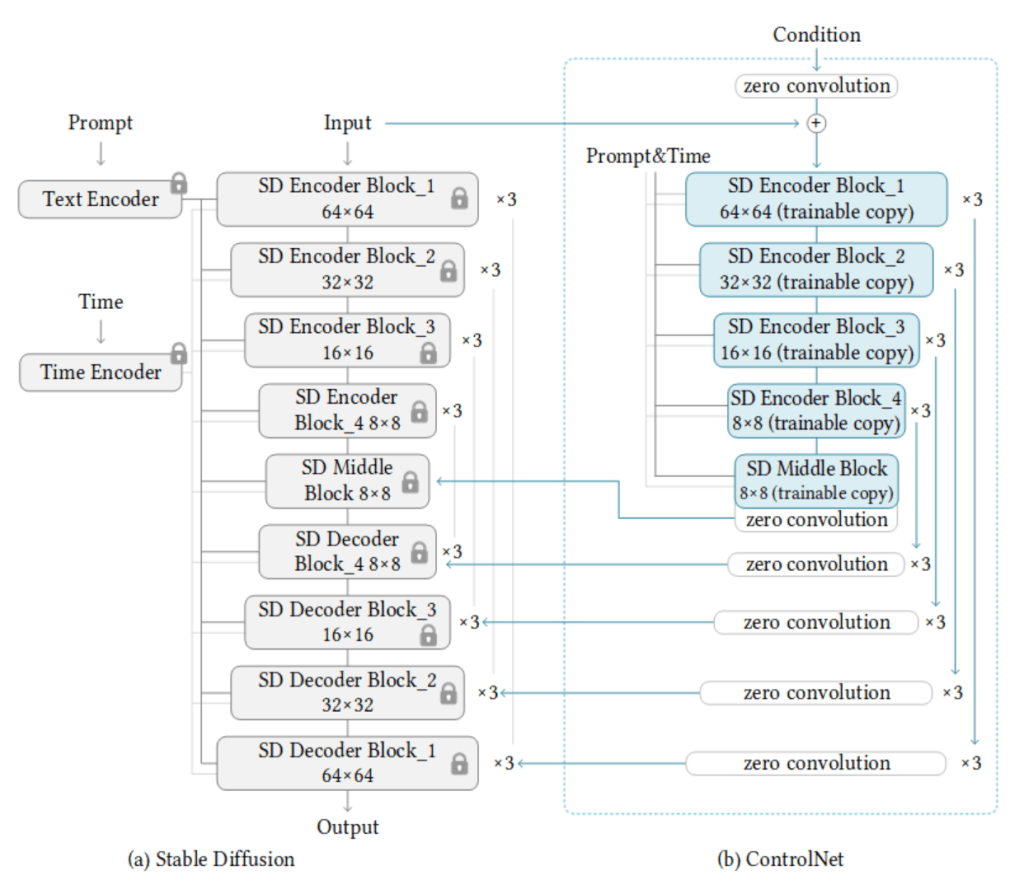

Stable Diffusion是一种基于潜在扩散模型(Latent Diffusion Models, LDM)的深度学习文本到图像生成模型

它通过将人类语言转换为机器能理解的数学向量,并与语义向量结合,从纯噪声开始逐步去除噪声,生成图片信息隐变量,最后将图片信息隐变量转换为一张真正的图片。

Stable Diffusion采用UNetModel这种Encoder-Decoder结构来实现扩散过程,包括三个模块:

- Text Encoder(蓝色模块):将人类语言转换成机器能理解的数学向量。

- Image Decoder(橙色模块):将图片信息隐变量转换为一张真正的图片。

Stable Diffusion模型在文本生成图像的深度学习应用场景中表现突出,例如通过给定文本提示词(text prompt),该模型会输出一张匹配提示词的图片。它还可以应用于其他任务,如内补绘制、外补绘制,以及在提示词(英语)指导下产生图生图的翻译等。

Stable Diffusion是一种基于概率密度函数的扩散过程,它通过逐步将高斯噪声添加到初始图像中,并使用一个编码器-解码器网络来逐步还原出原始图像。

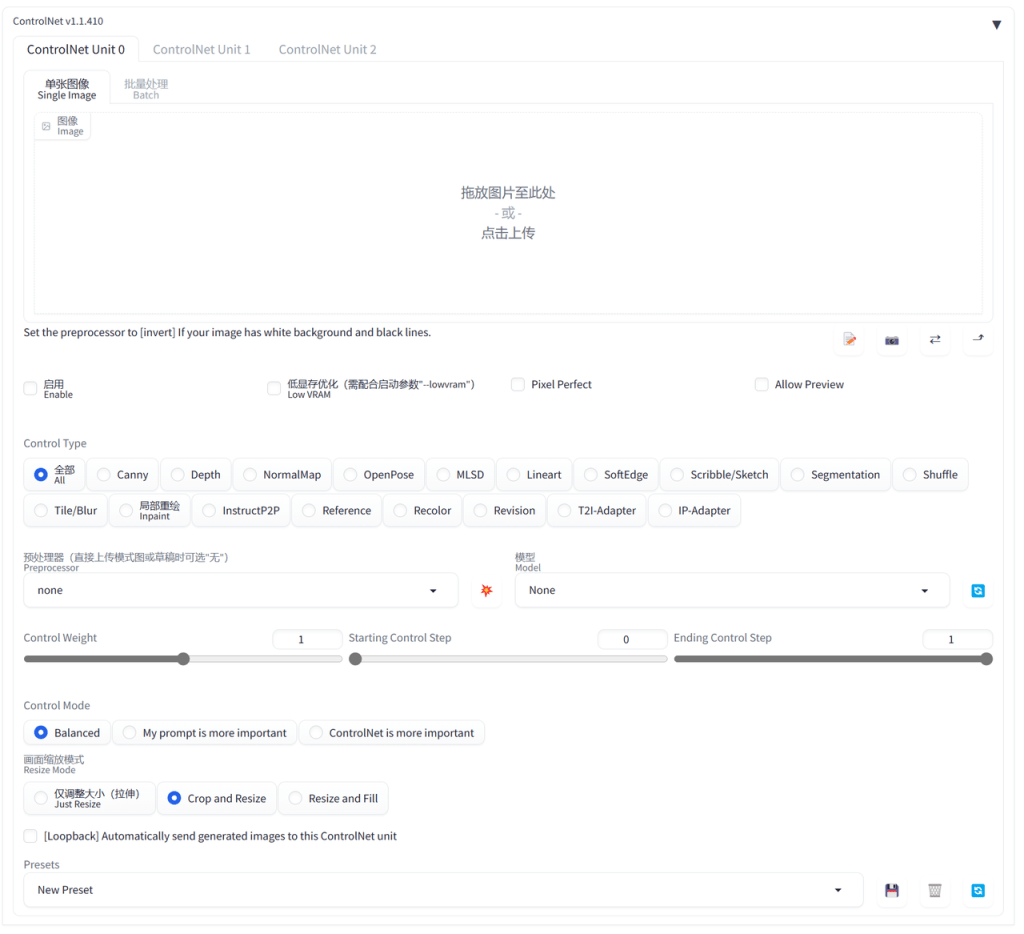

ControlNet是一个功能强大的插件

它为Stable Diffusion模型引入了新的控制方式,可以额外控制人物的具体姿势、景深、线稿上色等细节,为AI图像生成提供了更稳定的控制画面。

ControlNet插件的主要优势在于其简单易用的特性,它能够有效地帮助人们完成复杂的图像处理任务。ControlNet把每一种不同类别的输入分别训练了模型,目前公开的有下面14种控制方式,分别是1.0版本时就有的:Canny、Depth、MLSD、Normal、OpenPose、Scribble、SoftEdge、Seg,和1.1版本新增的:Lineart、Shuffle、Tile、inpaint、iP2P、Reference。

此外,ControlNet插件的另一个优点是它支持骨骼绑定、精准控线、语义分割、依据3D视图的法线进行绘图、线稿上色、依据深度图结构透视精准重绘等功能。这些功能使得ControlNet插件在图像处理方面具有更广泛的应用前景。

相比Stable Diffusion而言,而Control Net则是一种可以用于控制AI图像生成的插件,它通过额外的输入来控制预训练的大模型,如Stable Diffusion,允许用户对生成的图像进行精细的控制。

Stable Diffusion Control Net的发展历程可以追溯到2010年代初,当时深度学习和计算机视觉领域的研究人员开始探索使用生成对抗网络(GAN)进行图像生成。GAN是一种二元生成模型,它通过训练两个神经网络(生成器和判别器)来生成图像。在GAN的基础上,研究人员开始探索条件生成对抗网络(CGAN)技术,这种技术可以通过额外的条件来控制生成图像。

随着CGAN技术的不断发展,研究人员开始尝试将预训练的模型作为条件生成器,并将另一个神经网络作为判别器来训练一个CGAN模型。这个CGAN模型可以使用额外的输入来控制生成图像,从而实现了对AI图像生成的更精细控制。在这个过程中,一些研究人员发现,使用Stable Diffusion作为条件生成器可以生成更高质量的图像。

为了更好地理解Stable Diffusion Control Net的发展历程,我们可以将其分为以下几个阶段。

第一阶段:最早的简单控制网络

这个阶段的研究主要是将简单的控制网络与GAN结合在一起,通过额外的输入来控制生成图像。例如,研究人员将一个简单的卷积神经网络(CNN)作为条件生成器,并使用另一个CNN作为判别器来训练一个CGAN模型。这个CGAN模型可以通过额外的输入来控制生成图像的样式和特征。

第二阶段:复杂的控制网络结构

随着GAN和CGAN技术的发展,研究人员开始尝试使用更加复杂的控制网络结构来提高生成图像的质量和多样性。例如,他们将多个条件生成器和判别器组合在一起,构成一个更加复杂的CGAN模型。此外,他们还尝试使用了自编码器-解码器网络、变分自编码器等复杂结构来提高生成图像的质量。

第三阶段:先进的控制网络技术

为了更好地控制生成图像的过程和结果,研究人员开始探索更加先进的控制网络技术。例如,他们尝试使用了强化学习、梯度下降等技术来优化CGAN模型的训练过程。此外,他们还探索了使用注意力机制、Transformer等先进的神经网络结构来提高CGAN模型的性能和多样性。

总的来说,Stable Diffusion Control Net的发展历程是一个不断探索和改进的过程。随着技术的不断发展,这种技术已经成为了图像处理和计算机视觉领域中的重要工具之一,并被广泛应用于各种应用场景中。

ControlNet的发展历程是一个充满挑战与创新的历程,其中涉及许多开创者及相关故事。

以下是Stable Diffusion的Control Net发展历程中一些关键的开创者和他们的贡献:

- 伊恩·古德费洛(Ian Goodfellow)和杰里米·科勒(Jeremy Coheh):这两位研究者于2014年提出了生成对抗网络(GAN)的概念,并展示了它在图像生成方面的潜力。这一创新为后续的Control Net技术发展提供了基础。

- 约瑟夫·朱(Joseph Jun)和戴维·尤因(David Ewing):这两位来自斯坦福大学的研究者于2017年开始探索使用条件生成对抗网络(CGAN)技术来控制AI图像生成。他们提出了一种名为“深度条件生成对抗网络”(DeepConditional GAN,DCGAN)的方法,这种方法使用额外的条件来控制生成图像。这一开创性工作为Control Net的发展奠定了基础。

- 丹尼尔·西蒙(Daniel Simon)和亚历山大·乌亚纳耶夫(Alexander Ulanoy):这两位研究者于2019年开始探索使用Stable Diffusion模型作为条件生成器,并使用另一个神经网络作为判别器来训练CGAN模型。他们的工作证明了使用Stable Diffusion作为条件生成器可以生成更高质量的图像。这一重要突破推动了Control Net技术的进一步发展。

- 凯文·凯利(Kevin Kelly)和约翰·霍兰(John Holland):这两位研究者于20世纪60年代提出了“控制论”(Cybernetics)这一概念,并推动了关于自我组织和复杂系统的研究。他们的开创性工作为Control Net提供了理论基础和灵感来源。

这些开创者的研究和发现,为Stable Diffusion Control Net的发展历程铺平了道路。他们的开创性工作不仅为这一技术树立了里程碑,也为未来的研究者和实践者提供了宝贵的参考和灵感来源。

绝对要点赞我们年轻的同胞,特别是像张吕敏这样的中国青年,2021年本科毕业就已经在斯坦福攻读博士学位,真是令人钦佩。他为我们带来了一项令人兴奋的创新——ControlNet模型。这个概念是如此前瞻性,它通过引入额外的输入来实现对预训练的大型神经网络(例如,stable diffusion)的控制。其本质实际上是一种端对端的训练方法,虽然早在2017年就有类似的AI模型出现,但这一次,借助了像stable diffusion这样的顶尖大模型,使得端对端的训练迎来了更广阔的应用前景。

ControlNet的出现为文本生成图像等大型模型带来了崭新的可能性。它巧妙地解决了文生图大模型面临的一个关键问题:传统的基于关键词的控制方法往往无法满足对细节精确控制的需求。这意味着我们可以更精确地引导模型生成我们想要的内容,从而开辟了新的可能性。

这个年轻的研究者张吕敏的工作,无疑为我们展示了创新精神和对技术的卓越理解的典范。我们期待着看到ControlNet模型在人工智能领域的更多应用,以及它如何为我们的数字世界带来新的前景。

三、总结

让我们一起携手,共同探索ControlNet模型的未来,为信息传播的稳定性和受控性开启新的篇章。让我们一起揭开人工智能和机器学习的神秘面纱,以期在不断发展的计算机科学领域中,为知识的传播和控制提供新的视角和解决方案。通过共同努力,我们一定能够为全球的信息传播树立新的里程碑,开启一个更加稳定、高效和繁荣的未来。

下一篇文章,我们将为大家带来Stable Diffusion的Control Net的ControlNet的基本功能介绍,敬请期待~

兔兔科技

兔兔科技

AI作品赏析

AI作品赏析 JAVA Programming

JAVA Programming JOY MOVING

JOY MOVING Linux

Linux

最新评论

真不错